![Dibujo20130526 solitary wave reflecting from the barrier]()

Ya puedes disfrutar mi nuevo podcast para Trending Ciencia siguiendo este enlace. Como siempre, una transcripción del audio.

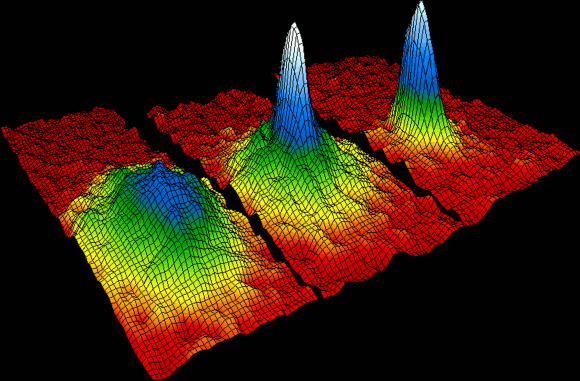

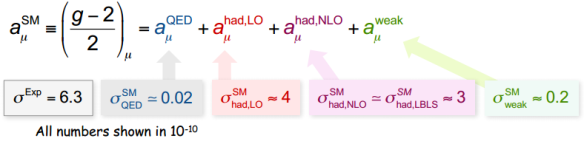

Como tema he elegido un artículo aparecido en la revista Nature Communications el pasado 14 de mayo titulado “Controlled formation and reflection of a bright solitary matter-wave,” o “Formación controlada y reflexión de ondas de materia.” Su primera autora, Anna Marchant, es doctoranda en la Universidad de Durham, Reino Unido, en el grupo de investigación de Simon Cornish. En este artículo se ha logrado propagar un solitón en un condensado Bose-Einstein de átomos de rubidio 85 a lo largo de una distancia de ~1,1 mm durante unos 150 ms. El solitón se ha propagado sin cambiar de forma (sin dispersión apreciable). Además se ha estudiado la reflexión de dicho solitón contra una barrera de potencial repulsiva con forma de gaussiana. Aunque aún no se ha observado el efecto túnel (la transmisión del solitón a través de la barrera) ni tampoco las colisiones mutuas entre varios solitones, este nuevo trabajo me ha resultado muy interesante, pues combina dos de mis pasiones, la teoría de solitones y los estados de Bose-Einstein como análogos de medios ópticos no lineales. Como siempre, permíteme que te cuente qué es un solitón, qué es un condensado de Bose-Einstein y que resuma los resultados que se han logrado.

El artículo técnico es A. L. Marchant, T. P. Billam, T. P. Wiles, M. M. H. Yu, S. A. Gardiner & S. L. Cornish, “Controlled formation and reflection of a bright solitary matter-wave,” Nature Communications 4: 1865, 14 May 2013.

Uno de los avances más importantes en la física-matemática de la segunda mitad del siglo XX ha sido el desarrollo de la teoría de solitones. Los solitones son ondas viajeras que se propagan sin cambiar de forma en un medio no lineal. La teoría clásica de ondas estudia las ondas lineales, como las ondas de luz con las que vemos o las ondas de sonido con las que oímos. Las ondas lineales obedecen el llamado principio de superposición. En el caso de ondas de sonido, si tocas varias notas a la vez en un piano, escucharás la suma de todas esas notas a la vez, lo que produce la armonía, pero por muy complicado que sea el sonido resultante siempre se puede descomponer en los armónicos (las notas) que lo forman.

Además de las ondas lineales de la teoría clásica de ondas, la teoría moderna de ondas incluye las ondas no lineales, que se clasifican en diferentes tipos. Por ejemplo, las olas del mar que rompen en la orilla de la playa son ondas no lineales. La amplitud de la onda y su velocidad varían conforme la onda avanza (recuerda que para ondas lineales la amplitud y la velocidad son constantes). La ola del mar rompe en la playa porque la velocidad de la onda depende de la amplitud y la parte superior de la ola se mueve más rápido que la parte inferior de la ola, con lo que la parte superior de la ola se adelanta a la inferior, curvando la ola y haciendo que rompa en la playa. Hay muchos fenómenos físicos ondulatorios en los que no se cumple el principio de superposición y están regidos por la matemática de los sistemas no lineales.

Recomiendo leer en español a “Juan E. Nápoles Valdes, Arturo González Thomas, “Solitones, una no-linealidad no tan solitaria,” Revista digital Matemática, Educación e Internet, Enero 2006.

Los solitones son uno de los tipos de ondas no lineales más famosos. La historia de su descubrimiento es tan curiosa que merece ser recordada. En 1834, durante un paseo a caballo por los alrededores de Edimburgo, en el Union Canal en Hermiston, muy cerca del campus Riccarton de la Universidad Heriot-Watt, el físico escocés John Scott-Russell observó cómo una barcaza era remolcada a lo largo de un canal estrecho tirado desde tierra por dos caballos. Mientras Russell, contemplaba el espectáculo, la barcaza se detuvo de repente, provocando un movimiento violento del agua. Ante el asombro de Russell, se levantó una ola en la proa de la barcaza que se desplazó a gran velocidad hacia delante, formando una única ondulación de gran altura, como una montaña de agua redondeada. Esta onda solitaria continuó su recorrido por el canal, sin variar su forma o reducir la velocidad. Russell persiguió a la enigmática ola montado a caballo durante más de dos kilómetros, hasta que la perdió de vista entre las curvas del canal.

La onda solitaria observada por Russell era muy enigmática porque no tenía explicación matemática en su época. Cuando se lanza una piedra a un estanque se forman pequeñas ondulaciones que se extienden en círculos concéntricos, cada vez de menor amplitud, hasta que se difuminan en la orilla. Pero la onda solitaria que observó Russell en el canal era un ola única sobre la superficie en calma del agua que mantenía su forma intacta mientras avanzaba. Russell decidió estudiar en detalle estas ondas, para lo que estudió cómo reproducirlas en su laboratorio. En sus estudios descubrió que la amplitud de la onda es proporcional a la velocidad de la onda y calculó la relación que hay entre la velocidad de la onda y la profundidad del canal. En 1844 publicó sus resultados, aunque con cierta polémica, pues varios expertos en ondas, como Airy y Stokes afirmaron que dichas ondas permanentes no podían existir. En el año 1870 Boussinesq desarrolló la teoría matemática que explica estas ondas, resolviendo el enigma de su formación. Las ondas solitarias son soluciones matemáticas de las ecuaciones de la física de fluidos con la forma de una función matemática llamada secante hiperbólica.

![Dibujo20130526 attractive interactions present in a bright solitary matter-wave]()

En su artículo, Boussinesq presentó varias ecuaciones, por ello, hoy en día, la ecuación más sencilla que descubrió Boussinesq para describir el fenómeno se conoce con el nombre de sus dos redescubridores, que además la estudiaron en detalle en 1895, Korteweg y su estudiante De Vries. La ecuación de Korteweg-de Vries es una ecuación en derivadas parciales no lineal que presenta dos términos cuyo efecto es opuesto. Por un lado un término dispersivo que trata de ensanchar las ondas solitarias y un término no lineal que trata de comprimir dichas ondas. El resultado de este tira y afloja es una solución de equilibrio, el solitón, que mantiene su amplitud y su anchura constantes.

La ecuación de Korteweg-de Vries y sus soluciones fueron consideradas una rareza científica con poca importancia práctica y teórica, hasta el trabajo numérico de Zabusky y Kruskal en 1965. El genial Enrico Fermi propuso estudiar por ordenador cómo se distribuía la energía en un sistema acoplado de osciladores no lineales. En 1953, Fermi, Pasta y Ulam, junto a la informática Mary Tsingou realizaron experimentos numéricos por ordenador. Para su sorpresa aparecía una fenómeno de recurrencia inesperado que parecía violar las leyes de la termodinámica. Los resultados se publicaron en 1955, un año despúes de la muerte de Fermi. Zabusky y Kruskal en 1965 pretendían entender la razón del fenómeno de recurrencia observado en el experimento de Fermi-Pasta-Ulam-Tsingou. Para ello construyeron un modelo continua del sistema de osciladores acoplados que resultó ser la ecuación de Korteweg-de Vries. Las ondas solitarias de esta ecuación se comportaban como partículas y en colisiones mutuas, dos a dos, recuperaban su forma, velocidad e identidad. Por ello, llamaron a estas ondas que parecían partículas con el neologismo “solitones.” La robustez de los solitones en sus interacciones mutuas era la explicación del fenómeno de recurrencia observado por Fermi-Pasta-Ulam-Tsingou.

Kruskal decidió estudiar en detalle las razones matemáticas que explicaban la gran robustez de los solitones ante interacciones. Junto a tres colegas, Gardner, Greene, y Miura observaron que la ecuación de Korteweg-de Vries estaba relacionada con las soluciones de la ecuación de Schrödinger de la mecánica cuántica. La expresión matemática del solitión se podía interpretar como un potencial para un partícula cuántica y utilizando las técnicas matemáticas desarrolladas en física cuántica para estudiar las partículas en potenciales, la teoría de la dispersión de Gelfand-Levitan-Marchenko, se podía obtener la solución general de la ecuación de Korteweg-de Vries. Esta ecuación era integrable. La nueva técnica se denominó transformada espectral inversa y corresponde a una versión no lineal de la técnica de transformada de Fourier que se utiliza en la teoría de ondas lineales.

Se encendió la mecha de una bomba que explotó en 1970. Se buscaron solitones en medios líquidos, sólidos, gaseosos, en circuitos electrónicos, en óptica, en superconductores, en biología, etc. Hay solitones por doquier. Por ejemplo, la gran mancha roja de Júpiter es una onda de tipo solitón. También es un soiltón la solución de tipo agujero negro de las ecuaciones de la gravedad de Einstein.

No sólo buscaron solitones los físicos, también los matemáticos buscaron otras ecuaciones integrables y desarrollaron nuevas técnicas matemáticas para estudiarlas. Quizás el resultado más importante fue el descubrimiento en 1971 de los rusos Zakharov y Shabat de una ecuación no lineal de Schrödinger que era integrable y que aparecía en la física de plasmas. En 1973 el japonés Hasegawa y el estadounidense Tappert (ambos investigadores de los Laboratorios Bell en EEUU) descubrieron que había solitones descritos por la ecuación de Zakharov y Shabat en fibra óptica no lineal. Como la fibra óptica es el medio unidimensional por excelencia, la tecnología de las fibras ópticas era el nicho natural para la teoría de los solitones. Pero observar estas ondas era muy difícil, porque las fibras ópticas tenían pérdidas muy grandes.

En 1979, se redujeron las pérdidas de las fibras ópticas hasta sólo 0,2 dB/km, lo que permite propagar un pulso de luz a lo largo de 50 km de fibra con una atenuación de la intensidad luminosa de sólo un 10% de su valor inicial. En 1980, Mollenauer, Stolen y Gordon (también de los Laboratorios Bell) lograron transmitir solitones ópticos de 7 ps de duración a lo largo de una fibra. Desde entonces el campo de los solitones ópticos es uno de los más activos de la investigación en la actualidad.

![Dibujo20130526 bose-einstein condensate]()

Un condensado de Bose-Einstein es un estado de la materia que se da en ciertos materiales a muy baja temperatura. En este estado de la materia, todos los átomos que lo constituyen se encuentran en el nivel de mínima energía, denominado estado fundamental. Descubierto en 1924 para los fotones por el indio Bose y por Einstein, no fue obtenido en laboratorio hasta 1995 por Cornell y Wieman al enfriar átomos a pocos nanokelvin por encima del cero absoluto. El condensado de Bose-Einstein fue la “molécula del año” según la revista Science en 1995 ya que se trata de un sistema cuántico macroscópico similar a una molécula pero con millones de átomos. Un átomo en un gas se mueve a una velocidad de unos unos 1000 km/h (unos 300 m/s) pero un condensado de Bose-Einstein se mueve a sólo 1 cm/s. Un condensado de Bose-Einstein es respecto a la materia ordinaria, como la luz de un láser es respecto a la de una bombilla. Gracias a ello se puede fabricar un láser de átomos, que en lugar de producir un haz de luz como un láser óptico, produce un haz (coherente) de átomos. En 1997 Ketterle fabricó el primer láser de átomos que producía un haz de átomos de sodio.

Recomiendo leer a Raúl Toral, “Nobel de Física. Condensado de Bose-Einstein,” Investigación y Ciencia, 2001.

El espín de un átomo depende del número de sus electrones de valencia. Cada electrón aporta un espín 1/2, por lo que si hay un número par de electrones de valencia el átomo es un bosón y si hay un número impar se trata de un fermión. El comportamiento colectivo de los bosones y de los fermiones es muy diferente. Recuerdo ahora una analogía que proponía el profesor Raul Toral en 1995 en la revista Investigación y Ciencia con motivo de la concesión del premio Nobel de Física de 2001 a Cornell, Ketterle y Wieman, “por haber conseguido la condensación de Boe-Einstein en gases diluidos de átomos alcalinos”. “Como todas las comparaciones es incompleta e inexacta, pero puede ayudar a entender lo que ocurre. Imagina un grupo de personas que asisten a un concierto de música en un auditorio. El solista interpreta una partitura para violín y todos quieren estar lo más cerca posible del intérprete. Antes de empezar el concierto, todo el mundo tiene muchas ganas de hablar, moverse por el bar y pocas personas están sentadas. A medida que se aproxima el momento del concierto, la gente va perdiendo su energía, bajan el nivel de la voz y se acomodan en los asientos. Como todos se quieren sentar tan cerca como sea posible del solista (y las entradas no están numeradas), el primero en llegar se sienta en la silla más cercana, el segundo en la siguiente silla más cercana, y así sucesivamente. Este comportamiento humano es típico de los fermiones.”

“Los bosones, por otra parte, se comportan de una manera más peculiar. Cuando el segundo ve que la silla favorita ya está ocupada, no se conforma y en vez de irse a la siguiente silla, se acomda en la silla favorita, encima de la persona que ya la ocupa. Una situación que a los bosones parece no importarles. De hecho, el tercero también se sienta en la misma silla, y así hasta que llega un momento en que una fracción muy elevada de los bosones se encuentran en esa silla favorita. En mecánica cuántica, las sillas son los estados cuánticos y la más cercana al intérprete, el estado fundamental. Cuando los bosones ocupan el estado fundamental, se comportan todos de la misma manera, como si todo el auditorio que se ha sentado en la misma silla, la más cercana al intérprete, abriera y cerrara los ojos al mismo tiempo, tosieran todos al unísono y aplaudieran con una simultaneidad perfecta.”

La descripción colectiva del comportamiento del estado condensado de Bose-Einstein se puede modelar como una ecuación de campo medio llamada ecuación de Gross-Pitaevskii. En este ecuación tridimensional las interacciones entre los átomos son descritas por un término no lineal. La versión unidimensional de la ecuación de Gross-Pitaevskii corresponde a una ecuación de Schrödinger no lineal similar a la estudiada por Zakharov y Shabat, que presenta ondas de tipo solitón. Estas soluciones de tipo solitón, en sentido estricto, sólo aparecen en la versión unidimensional de esta ecuación, es decir, cuando las interacciones entre los átomos del condensado son atractivas y el condensado se puede aproximar por un medio unidimensional (similar a una fibra óptica). Reproducir estos solitones exactos en los experimentos con átomos ultrafríos es muy difícil porque requiere atrapar el condensado en un trampa muy alargada y es muy difícil lograr que el solitón se propague un tiempo suficiente para poder estudiar sus propiedades.

Por fortuna, en el caso tridimensional también aparecen ondas solitarias en la ecuación de Gross-Pitaevskii, ondas que son análogas a los solitones, pero que son menos robustas en interacciones mutuas porque dicha ecuación no es integrable. Estas ondas solitarias tienen muchas semejanzas con las soluciones de solitón y son más fáciles de observar en los experimentos.

Las ondas solitarias fueron observadas por primera vez en condensados de Bose-Einstein de átomos de litio 7 en el año 2002 y en átomos de rubidio 85 en el año 2006. En ambos casos se utilizó la llamada resonancia de Feshbach para cambiar las interacciones de repulsión entre los átomos en interacciones atractivas, ya que en el primer caso aparece una inestabilidad que provoca el colapso de estas ondas. En estos estudios pioneros se lograron trenes de ondas solitarias que se asemejaban a las soluciones matemáticas teóricas, pero como estas ondas contenían unos ≲ 1000 átomos, la descripción de campo medio no es aplicable en sentido estricto y la forma de estos ondas solitarias difería de las predicciones de la ecuación de Gross-Pitaevskii.

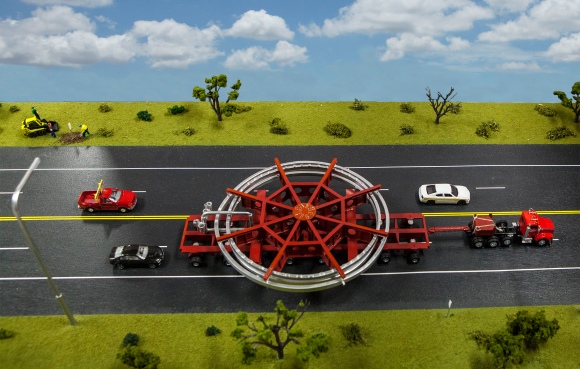

![Dibujo20130526 Experimental setup showing the glass science cell the crossed dipole trap used to create the BEC]()

Volvamos al nuevo trabajo aparecido en la revista Nature Communications el pasado 14 de mayo. Anna Marchant, de la Universidad de Durham, y sus colegas han logrado propagar una onda solitaria tridimensional, similar a un solitón, en un condensado Bose-Einstein de átomos de rubidio 85 a lo largo de una distancia de ~1,1 mm durante unos 150 ms. El solitón se ha propagado sin cambiar de forma (sin dispersión apreciable).

En el nuevo trabajo se presenta la formación controlada de ondas solitarias en un estado condensado de Bose-Einstein de átomos de rubidio 85. Gracias a la geometría experimental del condensado se ha logrado controlar con precisión la velocidad de los paquetes de ondas, lo que permite comparar de forma fiable los resultados experimentales con los obtenidos mediante simulaciones numéricas por ordenador de la ecuación de Gross-Pitaevskii tridimensional.

Para verificar la naturaleza corpuscular de estas ondas solitarias y verificar que su robustez es similar a la de las predicciones teóricas se ha estudiado su reflexión con una barrera de potencial repulsiva con forma gaussiana. Los resultados experimentales confirman las predicciones teóricas para la solución tridimensional de la ecuación de . Gross-Pitaevskii, aunque que destacar que difieren de la aproximación unidimensional, lo es decir, del comportamiento esperado para un solitón en sentido estricto.

El futuro de esta técnica es prometedor. No parece difícil cambiar la anchura de la barrera de potencial repulsiva con forma de gaussiana para lograr que sea más estrecha y permita observar el efecto túnel (la transmisión del solitón a través de la barrera), lo que podría permitir diseñar conmutadores, dispositivos que dejan pasar al solitón o lo reflejan controlando la anchura de la barrera. Tampoco se han estudiado las colisiones mutuas entre varios solitones, que también tiene importantes aplicaciones en el control de este tipo de ondas. En resumen, sin entrar en detalles técnicos, el nuevo artículo de Anna Marchant y sus colegas en Nature Communications combina dos de mis pasiones, la teoría de solitones y los estados de Bose-Einstein (que me interesan como análogos de medios ópticos no lineales exóticos). Los nuevos resultados abren el camino para nuevos estudios experimentales sobre la dinámica de ondas solitarias de materia que permitirán mejorar los llamados láseres de átomos, que producen pulsos coherentes de átomos en lugar de pulsos coherentes de luz. El campo de los solitones es sin lugar a dudas apasionante y será objeto de nuevos podcast.

Coda final. Sigue este enlace para oír el audio, si aún no lo has oído.

Archivado en:

Ciencia,

Física,

Noticias,

Physics,

Podcast en Trending Ciencia,

Recomendación,

Science Tagged:

Ciencia,

Condensado de Bose-Einstein,

Experimento,

Física,

Noticias,

solitones ![]()

![]()