![Dibujo20130726 la divulgacion a traves de los blogs - bienal fisica rsef]()

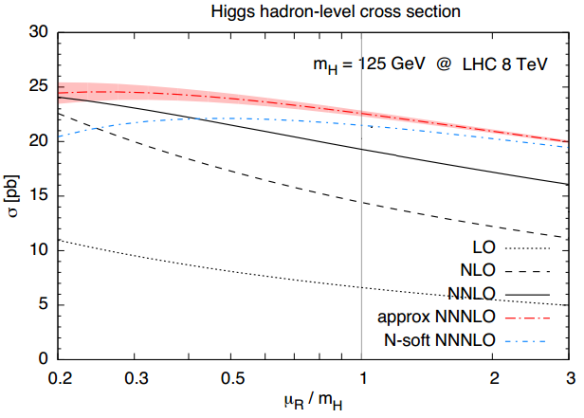

Todos los científicos tienen el deber de divulgar. No es una opción, es una necesidad. Los científicos somos los culpables de la situación actual de la ciencia en España. Muchos creen que divulgar es un hobby y que la cultura científica es un lujo prescindible. Craso error. Los científicos somos una de las profesiones mejor valoradas, sin embargo, la cultura científica de la sociedad y de nuestros políticos brilla por su ausencia. La única manera de lograr que los futuros gobiernos valoren la ciencia es lograr que la sociedad sepa lo que hacemos los científicos. Nos tenemos que poner en valor para que nos valoren. Todos los divulgadores debemos tratar de proselitar (atraer científicos a nuestra causa). Sin ciencia no hay futuro. Sin divulgación (parece que) no hay ciencia. Contar esto fue el objetivo de mi conferencia “La divulgación a través de los blogs” en el simposio del grupo especializado en divulgación de la física organizado en la 34 Bienal de la Real Sociedad Española de Física. Permíteme un resumen breve de mi charla.

![Dibujo20130726 quiz - que ha hecho el csic por la sociedad]()

Mi charla fue el lunes 15 de julio. El día anterior la contraportada de El País estaba dedicada a un científico. Varios científicos españoles aparecieron en dicha edición dominical con motivo de la tragedia del CSIC. ¿Quién es Avelino Corma? (la conferencia fue en Valencia y allí todo el mundo conoce a Corma, el gran pope de la Univ. Politécnica de Valencia). El artículo de El País nos aclara que Avelino tiene más de 900 artículos publicados en revistas internacionales (en realidad son unos 1100 en el ISI WOS) y que es uno de los ocho químicos más citados del mundo (su índice-h es mayor de 100). Pero no aclara en qué trabaja. ¿Debe el público general saber en qué trabaja Corma? ¿Debe saber qué ha hecho el Instituto de Tecnología Química (UPV/CSIC) por la sociedad española? ¿Qué cosas de tu vida diaria dependen del trabajo presente y pasado de Corma? Busca en la web del ITQ (UPV/CSIC) a ver si te enteras. Lo siento, no te será fácil. Yo sé cuáles son los trabajos que le han hecho famoso, pero no te los voy a contar.

¿Quién es Antonio Hernando? El artículo de El País nos aclara que Antonio es físico y dirige el Instituto de Magnetismo Aplicado (UCM/CSIC). Tiene unos 800 artículos en ISI WOS y un indice-h mayor de 40. ¿En qué trabaja? ¿Debe el público general saberlo? ¿Lo saben los lectores de esta entrada? ¿Qué cosas de la vida diaria dependen de su trabajo? El artículo aclara que su trabajo ha mejorado “desde la Alta Velocidad al control de los maltratadores con pulseras magnéticas.” Busca en la web del IMA (UCM/CSIC) esta información. ¿Te ha sido fácil?

La sociedad quiere saber, necesita saber. Nosotros tenemos la obligación de informarla. Pero buscar a ciegas en Google, muchas veces, no ayuda. La mayor parte de la información divulgativa que muestran los institutos del CSIC y nuestras universidades está muy sesgada, es parca, muy técnica y/o no es de acceso gratuito.

La comunicación científica en España falla y los culpables somos nosotros, los científicos, y nuestras instituciones, universidades y OPI del CSIC. La trágica situación que está pasando el CSIC en gran parte tiene su origen en el fracaso de la divulgación científica. Tenemos que ser conscientes de ello para poder corregirlo. La ciencia, los científicos tienen que abandonar la “torre de marfil.”

![Dibujo20130726 docencia - investigacion - transferencia]()

La universidad moderna nació con Wilhelm von Humboldt (1767-1835), en español Guillermo de Humboldt. Menos conocido que su hermano, Alexander, el “indiana Jones” naturalista y geógrafo, Guillermo fue “Responsable de Educación” bajo las órdenes del Ministro del Interior von Dohna. La universidad moderna es del pueblo y para el pueblo. No una universidad de las élites para unos pocos elegidos. Todos los estatutos de las universidades españolas siguen las directrices de la universidad de von Humboldt.

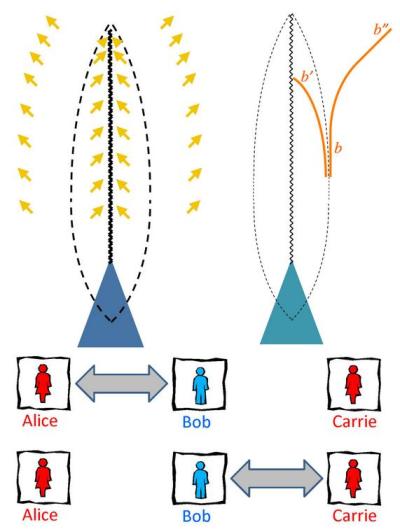

La universidad tiene tres deberes fundamentales: la docencia, la investigación y la transferencia. La universidad no es un ente abstracto, somos todos. El PDI (Personal Docente e Investigador) de las universidades tiene el deber de implicarse en las tres funciones básicas de la universidad (y el personal de los OPI (Organismos Públicos de Investigación) en las propias). No hay que ser un super-PDI (cual super-López) para cumplir con la obligación triple D+I+T; ser excelente en las tres cosas es casi imposible; siempre habrá mejores docentes, o mejores investigadores. Pero nuestra obligación es ser activos en transferencia, yo diría más, ser pro-activos. El PDI que es sólo docente, o sólo investigador, no está cumpliendo con su obligación.

La transferencia tiene tres focos básicos. Los egresados (la universidad para toda la vida, los máster profesionales, …), las empresas (contratos OTRI, spin-offs, patentes, …) y la sociedad (cultura científica y divulgación). En esta charla me centro en la divulgación, aunque no estoy diciendo que sea la única vía para el PDI que quiera implicarse en transferencia. Pero lo que quiero dejar claro es que la divulgación no hay que relegarla a ocasiones especiales (como el Año de la Física en 2005), debe ser algo continuo, debe formar parte íntegra de nuestras obligaciones. Ya hay mucha gente que se está dando cuenta y se han celebrado congresos específicos, pero queda mucho por hacer. Si todo estuviera hecho en transferencia y divulgación, la ciencia española no tendría los graves problemas que tiene.

![Dibujo20130726 unidades de cultura cientifica y sin ciencia no hay futuro]()

Muchos PDI e investigadores relegan la labor de la divulgación a las UCC (Unidades de Cultura Científica). Pero eso no basta. Todos tenemos que poner nuestro grano de arena. Las UCC (con poco personal y poco presupuesto) no dan abasto y necesitan una actitud activa de los investigadores. La divulgación te necesita. #sinDivulgación no hay futuro. #sinCiencia no hay futuro.

En una conferencia en un simposio, aunque uno vaya invitado, hay que realizar algún tipo de contribución. Mi propuesta es divulgar usando blogs porque es más fácil de lo que parece. La queja más habitual de las UCC es que contactar con los investigadores y saber qué trabajos priorizar a la hora de divulgar es muy difícil. Se crea un cuello de botella que relega la transferencia a lo más profundo de la torre de marfil. Mi propuesta es que para romper el cuello de botella de las UCC es necesario que los investigadores divulguen directamente el trabajo que desarrollan. Todos los grupos de investigación (o si son pequeños, varios grupos próximos unidos entre sí) deben divulgar su trabajo. Cada grupo debe tener un comunicador (un responsable de divulgación), a ser posible, un científico senior que conozca el trabajo del grupo y pueda ponerlo en contexto (tanto respecto al pasado como respecto al futuro). Su labor no debe estar dirigida hacia la UCC, sino a la sociedad en su conjunto. La sociedad quiere saber y tiene el derecho a saber.

![Dibujo20130726 divulgar con blogs - mas facil de lo que parece]()

Para realizar esta labor, mi recomendación es divulgar usando un blog del grupo (esta propuesta viene obligada porque me pidieron que diera una charla sobre cómo divulgar usando blogs, pero también porque creo que el blog es la mejor opción). A muchos científicos les puede parecer muy difícil divulgar a través de un blog. Pero recuerda, qué es un blog. Un blog es una página web con una línea temporal inversa, se presentan antes los últimos resultados publicados y todo lo presentado tiene una fecha.

Lo que yo propongo es usar los proyectos de investigación como marco para el desarrollo de las entradas del blog del grupo. Cuando se envía una solicitud de proyecto se describen las bases del trabajo a realizar y los resultados que se espera obtener a dos niveles, pues se ignora si el revisor será experto en nuestra área de trabajo o en áreas afines. La descripción menos técnica es ideal para entradas en un blog. Además, en el proyecto se presenta un cronograma detallando las fases de trabajo y se enumeran una serie de entregables. Toda esta información puede ir apareciendo de manera natural en un blog. No hay que divulgar todos los días. Cada cosa a su tiempo, a su ritmo. Cada entregable puede ir acompañado de una entrada (o varias) en el blog.

Imagina que quieres escribir una entrada describiendo tu último artículo. No la escribes el mismo día que te publican en la revista el artículo, a toda prisa. Desde el día que enviaste el artículo hasta el día de la aceptación has tenido varios meses para preparar una o varias entradas sobre el artículo, que aparecerán a su debido tiempo. Por ejemplo, una entrada en plan noticia sobre tus resultados y luego dos o tres artículos con las bases teóricas que faciliten que cualquiera pueda entender dicha noticia. Lo mismo pasa con tus trabajos enviados a congresos y conferencias, con las tesis que diriges, etc.

Igual que la solicitud de un proyecto no la suele escribir un investigador junior, la divulgación de los resultados del proyecto debería estar en manos de algún científico senior. No tiene que ser un gran divulgador, ni su objetivo es colmar su blog con portadas de Menéame. El objetivo es que cualquier ciudadano español que quiera enterarse de lo que financia con sus impuestos pueda hacerlo. Y además, que el personal de las UCC (que debería estar suscrito vía RSS a todos los blogs de los grupos de su universidad u OPI) y que cualquier comunicador científico (de los grandes medios o incluso aficionados) pueda conocer los resultados del grupo de investigación. La ciencia tiene que salir de la torre de marfil. Y es más fácil y menos costoso para los investigadores de lo que parece. Pretender que otro haga la labor que sólo uno puede hacer nunca es la mejor opción.

No recomiendo que sea un científico junior el responsable de la labor de comunicación del grupo por varias razones. La más importante es que no conoce el pasado, el presente y el futuro del grupo y de su línea de investigación. No tiene el bagaje suficiente para divulgar el proyecto, le falta una visión global y a largo plazo (algo muy importante en la divulgación, aunque muchos científicos lo olvidan). Además el personal junior debe centrarse en aprender a investigar con excelencia.

Mucha gente cree que los blogs son un ocio, una afición, que son muy personales y poco profesionales. Pero todo depende del objetivo que el bloguero se plantee. En mi propuesta no tienen cabida este tipo de blogs de divulgación “personales” (como el mío que estás leyendo ahora). Todo lo contrario, el blog del grupo debe ser lo más profesional posible. Una puerta del grupo hacia la sociedad (ciudadanos, empresas, futuros alumnos, científicos , colegas, etc.).

En resumen, no sé si he dejado muy claro mi propuesta, pero más o menos esto constituyó los primeros 15 minutos de mi charla en la Bienal de Física. El resto del tiempo lo dediqué a los detalles. Prometo una futura entrada. Continuará…

Archivado en:

Ciencia,

Física,

Noticias,

Physics,

Recomendación,

Science Tagged:

Blogs,

Ciencia,

Comunicación científica,

Conferencia,

Divulgación científica,

Noticias,

recomendación ![]()

![]()