![Dibujo20130815 watchmen - poderio visual - from marvel and dragondigital es]()

En el cómic “Watchmen”, el guionista inventa un mundo con superhéroes y taquiones, donde el quark strange y el charm se han descubierto en los años 50, el científico loco de turno hace experimentos para intentar encontrar los gluinos, y EEUU gana la guerra de Vietnam. Algo parecido hemos intentado hacer Mitchell Porter y yo en un hilo de PhysicsForums al que llamamos “The Wrong Turn of String Theory“, y para ello usamos varias numerologías, que he repescado aquí.

He titulado el post “Lo que pudo haber sido”, pues es como pensar en una historia alternativa de la física de partículas. Gracias a Francis por hacerme sitio para este guest post. Tenia ganas de hacer un resumen en castellano de todas estas cosas, y mi blog personal tiende a fragmentarse demasiado. No sé si necesito presentarme; ahora me dedico a cuestiones de redes sociales y asuntos informáticos, hace veinte años estudié física en la Universidad de Zaragoza y muchas de las cosas que he ido pensando -y arxivando- las podéis ver en mi página personal allí.

Sí, este post va de numerología. Dicho con más politesse, va de pistas que no tienen más fundamento que la mera numerología. Ya esta dicho. Veamos que tal sale. Si es demasiado denso o me salto cosas, siempre tenemos los comentarios.

1: Contando Partículas, o Numerología de Enteros

El primer gran tema es 128 = 84 + 44.

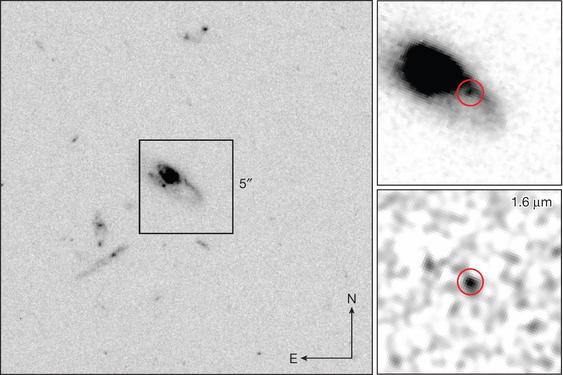

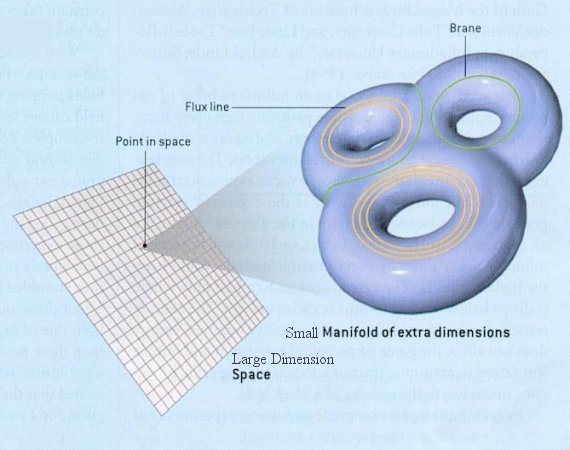

Hay un montón de papers de verdad, publicados y todo, sobre esta suma. El 128 es el número de componentes de un campo fermiónico en dimensión D=11 (Minkowski, uséase 10 espaciales + 1 temporal). [Aclaración: Alejandro se refiere al gravitino, un fermión de espín 3/2 asociado al gravitón, de espín 2; en D=11 hay fermiones de menos componentes, como los gauginos de espín 1/2 asociados a los bosones gauge; como aclara Alejandro en los comentarios, "cuando se compactifica a dimensiones más bajas, según cual sea la topología del espacio de compactificación, el gravitino se va descomponiendo en objetos tanto de espin 1/2 como de espin 3/2]. El 44 son las componentes del gravitón en D=11. Parece obvio que 128 no es igual a 44, así que la supergravedad se pega un tiro en el pie si insiste en tener igual número de componentes bosónicas que fermiónicas, ¿no?. Pues bueno, se salva porque llega al rescate un campo bosónico extra, un tensor antisimétrico de tres índices, que en D=11 tiene, justo, 84 componentes. ¿Qué significado tiene este campo? Una forma de verlo sería tirar del concepto de “central charges“, y que al colapsar esta supergravedad desde D=11 a D=4 apareciera una carga central con estas componentes. Otra forma, más entretenida, es mirar cuál es la fuente de la famosa membrana (2-brana) de D=11, y resulta que sí, que tanto ésta como su dual, la 5-brana, tienen su fuente en un campo de este tipo.

La construcción es super-elegante, y ahora solo bastaría tirar para abajo en el número de dimensiones usando Kaluza-Klein. Lo cual tiene su truquillo, porque bajo la alfombra de las dimensiones compactificadas se pueden sacar y meter los grados de libertad que queramos. Pero ingenuamente podríamos pensar que si tenemos 128 componentes bosónicas y 128 componentes fermiónicas, algo parecido vamos a tener en D=4.

¿Y qué es lo que tenemos hasta ahora? Bueno, pues depende de los neutrinos. En este post voy a suponer que el mecanismo que da masa a los neutrinos añade las componentes “derechas”, de forma que puede haber simultáneamente masa de Majorana y de Weyl. Lo típico de jugar al balancín (seesaw). Asumiendo estos neutrinos, llevamos observado:

1) Un gravitón, con dos componentes.

2) Un montón de fermiones, a cuatro componentes cada uno, sumando 96 componentes. Aquí me llama la atención que 96=84+12. Si miramos a las masas de los fermiones, tenemos que los de masa extremadamente pequeña, los tres neutrinos, suman 12 componentes. Pero también los de masa extremadamente grande, los tres colores del quark top, suman 12 componentes. Parece que tendríamos que tener una simetría que protege a los fermiones de saltar el balancín, y protegería a 84 de ellos, y otra simetría que debe protegerlos de adquirir una masa de escala electrodébil, y protegería a otros 84. ¿Es este el destino último de la 2-brana y la 5-brana?

3) Los bosones, a saber: El campo SU(3), con sus 8 gluones de espín 1, suma 16 componentes. El campo SU(2)xU(1), sin masa, tendría 8 componentes y el campo de Higgs, sin ruptura, cuatro. De ellas, al romperse la simetría, tres pasan a formar parte de W+, W− y Z, así que quedan por un lado 11 componentes en SU(2)xU(1) y por el otro el famoso bosón de Higgs, con una sola. En cualquier caso, suman 16+11+1= 28 componentes. Medio coincidentalmente, el grupo de isometrías de la 7-esfera tiene 28 componentes.

Total: 96 componentes fermiónicas, 30 componentes bosónicas. Eso es lo que los experimentales han encontrado hasta ahora. En total 126 componentes.

La cuenta la revisé hace muy poco en Twitter con Amarashiki, que andaba contando partículas, pero en su origen se debe a una observación de mi antiguo director de tesis, L. J. Boya, que en algún sitio comenta que el MSSM tiene 128+128 componentes. Por cierto que LJ tiene bastantes artículos de interés para los que gustan de E8 y de teoria de representaciones. (Full disclosure: en mis tiempos nos dedicamos a Susy Quantum Mechanics, así que no soy un experto en estos temas, no los he trabajado más allá de conversaciones de seminario).

El MSSM es una lata pero, en general, ¿qué ocurre si activamos el requisito de supersimetría? Pues algo curioso con los bosones gauge masivos: como tienen 3 componentes, se les tiene que pegar por lo menos un fermión de 4 componentes, o dos de Weyl, y eso significa que necesitan una partícula extra en el lado bosonico. El supermultiplete del Z0 se puede completar con el bosón de Higgs que acaba de descubrir el CERN, pero los del W+ y W− necesitan otros dos bosones. Los que hayais leido hasta aquí, haced un poco de “hep-ex-fiction” y asumid que en la siguiente ronda del LHC aparece un H+ (y un H−). Tendríamos un catálogo de 96 componentes fermiónicas y 32 componentes bosónicas, que incluirían el gravitón y estas dos “por descubrir”. Visto de otro modo, si a las 96 componentes fermiónicas descubiertas les pudiéramos sumar los 32 partners, usease gluinos (16), winos (8), zino (4), fotino (2) y gravitino (2), sumarían 128 componentes. Justo las que necesita un fermión de D=11. Así que el amigo Alan Moore estaba bastante inspirado cuando ponía al Dr Manhattan a buscar esos gluinos. Pero incluso si no se encuentran, no deja de ser curioso que estamos a punto de agotar la física de partículas quedándonos justo con la mitad de las partículas que uno esperaría haber encontrado en SuperGravedad. Bueno, casi la mitad, a falta de ese bosón cargado.

¿Y en dirección inversa, no tendríamos que buscar también los 96 escalares que acompañan a los fermiones del modelo estándar? Pues mira, aquí es donde yo iba camino de Damasco y se me tropezó el caballo y oí una voz que me decía… bueno, no, pero algo así. Resulta que estaba un poco mosca intentando entender por qué el señor Koide habia empleado relaciones que parecían (y sólo parecían) reglas de masas para mesones, y le di vueltas a lo de que el muón tiene más o menos la misma masa que el pión y que, nueva coincidencia numerológica, conocemos seis mesones cargados de espín cero. Justo lo que necesitamos… Mirando con más detalle, resulta que el espectro de “cuerdas abiertas orientadas” de QCD proporciona estos 96 escalares si no dejamos que el quark Top aparezca en los extremos de esta cuerda.

Dicho de otra forma, en lenguaje de grupos: la parte escalar de supersimetría parece tener una simetría global SU(5) que se descompone en SU(3)xSU(2) con asignación de carga eléctrica y de color similar a los 3 quarks dsb y a los dos quarks uc. El producto de una representacion 5 y una anti-5 de SU(5) se descompone en 24 + 1 y esos 24 son justo los 12 sleptones cargados y los 12 sneutrinos. El producto de una representación 5 por otra 5 se descompone en 15 + 10, y ese 15 contiene los 12 antiquarks de un color dado. Esto lo he contado por el arxiv de cuando en cuando, y también en el blog viejo de Dorigo.

Así pues, puede que todo lo que quede de los sfermiones sea el espectro de mesones y diquarks. No hay un modelo dinámico directo, y la cuerda abierta orientada esta prohibida en superstrings. Pero la cuenta de escalares coincide, carga a carga, con la que necesitamos. Ah, y está claro que el truco sólo funciona bien con tres generaciones y un quark top que sea mucho más pesado que QCD, para que no forme mesones y salgan las cuentas. Pocos modelos hay que exijan un mínimo de tres generaciones.

Por cierto, a ver si algún día alguien me explica a quién se le ocurrió llamar “sfermión” a un escalar, que es partícula de Bose.

Intermedio: bajando dimensiones

Volvamos un momento a lo de que nos han salido 28 componentes en el sector bosónico del modelo estándar. Visto como partículas, son 8 portadores de fuerza fuerte, 4 portadores de electrodébil, y un campo de Higgs en doblete. En realidad no pueden ser un subgrupo de SO(8); pero la conexión con la 7-esfera es un falso camino, por mucho que sea el camino que se exploró en la mayoría de los modelos, generalizando a partir de otros que se habían hecho para jugar con Kaluza-Klein en la 3-esfera.

A Witten se le ocurrió otro modelo. Debió pensar en Pati-Salam, SU(4)xSU(2)xSU(2), y jugando a que SU(4) es como SO(6) y a que SU(2)xSU(2) es como SO(4), parece obvio que Pati-Salam es el grupo de simetrías (de isometrías) de la variedad producto de la 5-esfera y la 3-esfera. Esta es una variedad de dimensión 8. Haciendo su cociente arbitrario por cualquier recorrido del grupo U(1), el amigo Edward se dio cuenta de que la resultante iba a ser de dimensión 7 y que su grupo de isometrías sería en general SU(3)xSU(2)xU(1). Esto es, Kaluza-Klein en D=11 prácticamente implica que cuando cocientemos a D=4 nos van a salir de regalo, si buscamos hacerlo de forma no trivial, los mismos grupos que tiene el modelo estándar. Pero estas variedades compactificadas no son esferas, que al tener la máxima simetría posible sería lo más elegante. Son justo su mitad, en un sentido: la esfera es la fibración de S3 sobre S4, y estas variedades son fibración de S3 sobre CP2. En algún sitio cuenta Atiyah de qué manera CP2 y S4 son una la mitad de otra: “branched covering“.

Es bastante interesante que haya que jugar con el modelo de Pati-Salam, sacándolo de un espacio compacto desde D=12. La gente de cuerdas tiene algunos casos en los que trepa a esta dimensión pero tiene que poner signaturas exóticas, 10+2 y cosas así. No se puede hacer una SUGRA decente más allá de D=11, pero parece que hay que visitar esa tierra. Puede que tenga que ver con que Pati-Salam necesita, al romperse, tener un campo que no es un campo gauge, el U(1) correspondiente a la simetría B-L. El espacio de D=12 válido sería el producto directo de una de las variedades de Witten por un U(1), y este grupo daría cuenta de la carga B-L. También Connes en sus modelos encuentra natural usar Pati-Salam primero y luego cocientar. Y hasta Baez y Huerta lo usan en su cuadrado para bajar desde SO(10) al modelo estándar.

El abandono de Kaluza-Klein fue, en mi opinión, otro accidente histórico. La revolución de turno en las supercuerdas dejó desmantelado el campo. Y Francis se pregunta si los cientificos siguen modas.

2: Poniendo Masas, o Numerología de Escalas.

He hablado de Koide, y es un tema que suele salir en comentarios, así que vamos a ello. ¿Me ha servido la visita al mundo de los números enteros y de las teorías de grupos y supercosas, conversión a cuerdas (open strings) incluida, para entender algo de las masas? Pues de momento no, pero tampoco me descuadra. Ya he dicho que me asombra la coincidencia entre masas de QCD (como el pión) y masas del modelo estandar (como el muón). Aproximando un poco aquí y allá, me atrevo a ponerlas todas juntas en seis niveles:

![\begin{array}{lllllll} &\nu_?, t_{rgb}& & & & \\ &\nu_?, b_{rgb}& B^+,B_c^+ & bu, bc & bb, bs, bd & \eta_b, \stackrel{b\bar s,b\bar d}{\bar bs,\bar bd} \\ &\tau, c_{rgb} & D^+, D_s^+& sc,dc & & \eta_c, \stackrel{c\bar u}{\bar cu}\\ &\mu, s_{rgb} & \pi^+, K^+& su, du& ss, sd, dd & K^0,\pi^0, \stackrel{s\bar d}{\bar sd}\\ &\nu_?, d_{rgb} \\ &e, u_{rgb}\end{array} \begin{array}{lllllll} &\nu_?, t_{rgb}& & & & \\ &\nu_?, b_{rgb}& B^+,B_c^+ & bu, bc & bb, bs, bd & \eta_b, \stackrel{b\bar s,b\bar d}{\bar bs,\bar bd} \\ &\tau, c_{rgb} & D^+, D_s^+& sc,dc & & \eta_c, \stackrel{c\bar u}{\bar cu}\\ &\mu, s_{rgb} & \pi^+, K^+& su, du& ss, sd, dd & K^0,\pi^0, \stackrel{s\bar d}{\bar sd}\\ &\nu_?, d_{rgb} \\ &e, u_{rgb}\end{array}]()

donde he completado cada nivel para que tenga dos partículas, a base de añadir los neutrinos con lo que sospecho sería su masa antes del see-saw. Creo que tenemos aquí un desdoblamiento o ruptura parcial de Pati-Salam, con leptones y quarks todavía alineados por SU(4), y que podemos plegarlo de nuevo, quedándonos en tres “generaciones”:

![\begin{array}{|l|} \hline \nu_2, b_{rgb}, e, u_{rgb}\\ \hline \tau, c_{rgb} , \nu_3, d_{rgb}\\ \hline \mu, s_{rgb} , \nu_1, t_{rgb} \\ \hline \end{array} \begin{array}{|l|} \hline \nu_2, b_{rgb}, e, u_{rgb}\\ \hline \tau, c_{rgb} , \nu_3, d_{rgb}\\ \hline \mu, s_{rgb} , \nu_1, t_{rgb} \\ \hline \end{array}]()

de forma que todas las relaciones de Koide que conocemos unen una partícula de cada nivel: por supuesto la original (e,mu,tau) pero tambien los demás de la “Koide Waterfall“: (s,c,b), (c,b,t) y (u,s,c) y (d,u,s). Cada uno de estos tripletes cumple la ecuación de Koide, aunque podemos argüir que no tiene demasiado mérito dado que sólo el Top tiene una masa medible. Y de alguna manera, la relación de Koide sobrevive al desdoblamiento.

La ecuacion de Koide de un triplete dado es ![M_i= M_{()} (1 + \lambda_i)^2 M_i= M_{()} (1 + \lambda_i)^2]() con las condiciones

con las condiciones ![\lambda_1+\lambda_2+\lambda_3=0 \lambda_1+\lambda_2+\lambda_3=0]() y

y ![\lambda_1^2+\lambda_2^2+\lambda_3^2=3 \lambda_1^2+\lambda_2^2+\lambda_3^2=3]() . Por tanto

. Por tanto ![M_{()} = (M_1+M_2+M_3)/6 M_{()} = (M_1+M_2+M_3)/6]() . Aquí hay una coincidencia muy llamativa, de las de numerología de escalas de energía. Resulta que

. Aquí hay una coincidencia muy llamativa, de las de numerología de escalas de energía. Resulta que

![M_{(e\mu\tau)} = 313.8 MeV M_{(e\mu\tau)} = 313.8 MeV]()

la masa correspondiente al triplete de leptones es igual a la masa del quark de QCD. Si ya no había ninguna razón para que el muón y el pión tuvieran masas cercanas, esto es una incógnita mayor, pero ahí esta. Ahora, resulta que es posible encajar las masas de s,c,b usando una masa ![M_{(scb)} M_{(scb)}]() que sea el triple de la de los leptones. Esto es, 941.4 MeV, aunque no hay por que preocuparse del valor concreto, simplemente lo curioso es que basta un factor tres para que encajen un triplete de leptones y uno de quarks. Y una vez encajadas s,c,b podemos predecir la masa del top volviendo a aplicar Koide sobre c,b,t. El resultado: 173.26 GeV.

que sea el triple de la de los leptones. Esto es, 941.4 MeV, aunque no hay por que preocuparse del valor concreto, simplemente lo curioso es que basta un factor tres para que encajen un triplete de leptones y uno de quarks. Y una vez encajadas s,c,b podemos predecir la masa del top volviendo a aplicar Koide sobre c,b,t. El resultado: 173.26 GeV.

Es posible que algunos de vosotros hubierais leído en su día la critica de Lubos sobre la ecuación de Koide. Lamentablemente, Motl tiende a ignorar los preprints que considera una pérdida de tiempo, y eso suele incluir los míos. Así que en su crítica desconocía los resultados para quarks. Y seguramente no habría ni siquiera tomado en cuenta las masas de niveles similares a QCD, dado que la ideología dominante es que todos los valores de las masas descienden desde los valores de los acoplos de Yukawa en la escala de Planck, sin ninguna condición especial a la escala de QCD.

Pero visto desde abajo, resulta que la cuerda de QCD tiene la escala de masas necesaria para Koide y los sabores necesarios para imitar supersimetría con tres generaciones. Puede que la supercuerda de 1971, la de los modelos duales de quarks y gluones, fuera después de todo el modelo correcto.

Archivado en:

Ciencia,

Física,

Matemáticas,

Mathematics,

Noticias,

Physics,

Science Tagged:

Ciencia,

Curiosidades,

Física,

Física teórica,

Matemáticas,

Noticias,

numerología,

Partículas elementales,

Supergravedad,

Teoría de cuerdas (String Theory) ![]()

![]()