Hace una década estuve estudiando cómo simular por ordenador el flujo de sangre en el ventrículo izquierdo para compararlo con las medidas de la perfusión cardíaca en los ecocardiógrafos de contraste. Al final todo quedó en una solicitud de proyecto de investigación que no nos concedieron y decidí cambiar de tema de estudio; sin embargo, me sigue gustando leer artículos científicos que presentan los resultados que nosotros podríamos haber obtenido. Se publica en Physics of Fluids una simulación del flujo de sangre en el ventrículo izquierdo que muestra que los patrones del flujo no afectan a la función cardíaca (su efecto es insignificante), aunque mejoran el mezclado de la sangre y el tiempo de residencia de las células sanguíneas en el ventrículo. Me ha sorprendido que este resultado fuera el mismo que imaginaba el cardiólogo con el que yo colaboraba. Quizás los que rechazaron nuestro proyecto también lo imaginaban. Por cierto, hoy en día muchos cardiólogos utilizan en su práctica clínica la ecocardiografía de contraste que permite visualizar el flujo de la sangre en el ventrículo izquierdo gracias a la cavitación de las microburbujas (que producen los contrastes que se inyectan por vía intravenosa, normalmente femoral). Aunque influya poco en la función cardíaca, el flujo depende mucho de la condición cardíaca y un flujo anómalo permite detectar muchas patologías. El nuevo artículo es Jung Hee Seo, Rajat Mittal, “Effect of diastolic flow patterns on the function of the left ventricle,” Physics of Fluids 25: 110801, 23 Aug 2013.

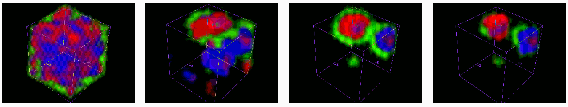

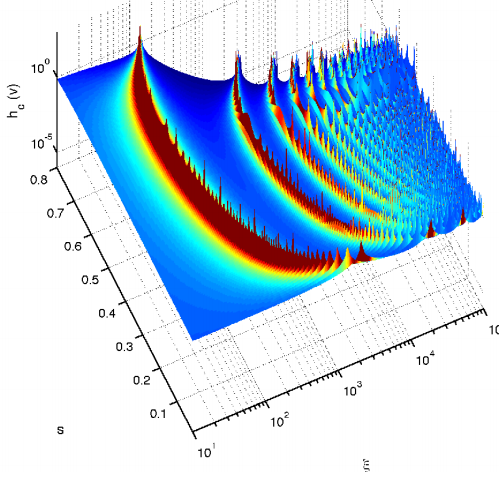

El método más utilizado para simular el flujo en el ventrículo izquierdo (y en el corazón en general) es el método del contorno sumergido (IBM por Immersed Boundary Method), que permite simular el movimiento elástico del músculo junto al del fluido (cuyo número de Reynolds es moderado Re∼4000). Se ha utilizado una malla tridimensional de 256 × 256 × 384 (unos 25 millones de elementos), que parece suficiente. Como condiciones de contorno para la entrada de fluido a través de la válvula mitral (desde la aurícula izquierda) y para su salida por la válvula aórtica (hacia la aorta) se utiliza un modelo de parámetros concentrados que simula los sistemas circulatorios periférico y pulmonar. No entraré en más detalles pues se trata de técnicas bastante estándares en la simulación del corazón y no hay novedades al respecto en el nuevo artículo.

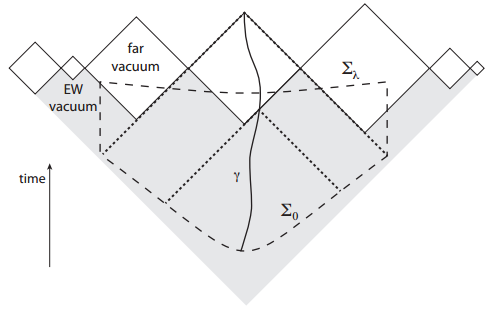

Se ha supuesto un latido cardíaco de 60 pulsaciones por minuto (un ciclo cardíaco por segundo) y se ha simulado un ciclo cardíaco en el ventrículo, es decir, la entrada de fluido a través de la válvula mitral (onda E) y su salida a través de la aórtica (onda A). Un parámetro clave es el cociente E/A entre las velocidades de entrada (llenado del ventrículo) y salida (llenado de la aurícula); utilizando ecocardiografía se puede estimar el cociente E/A, que es utilizado en la práctica clínica. En un corazón sano el cociente E/A ~ 1,2, siendo valores mucho más grandes (E/A ~ 2) o más pequeños que la unidad (E/A ~ 0,5) indicadores de disfunción cardíaca. Por ejemplo, con la edad la pared de la aurícula se vuelve más rígida y se produce un incremento de presión en el ventrículo reduciendo la velocidad de llenado (E) y el cociente E/A.

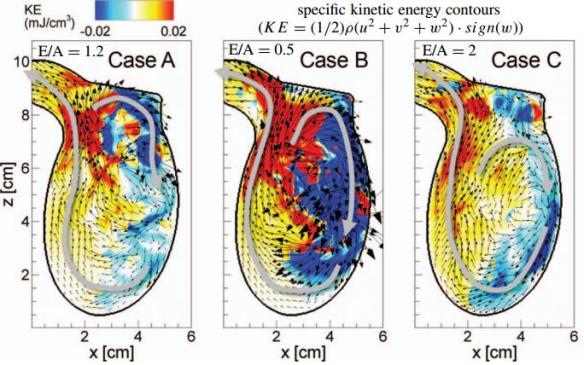

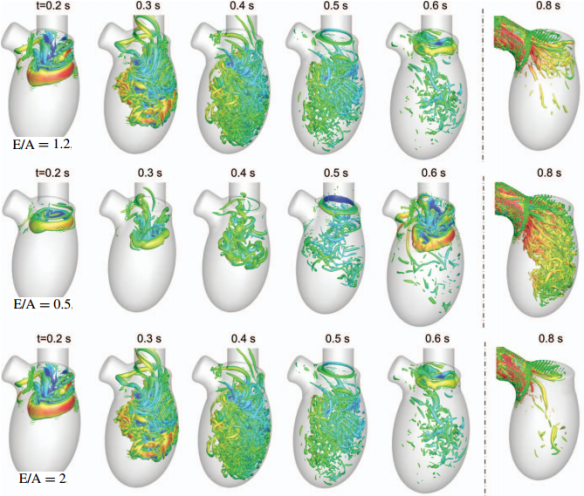

Las simulaciones muestran que para E/A=1,2 (corazón sano), alrededor de los 0,2 segundos aparece un gran vórtice con forma anular que penetra dentro del ventrículo, donde el flujo está en reposo (desprovisto de vórtices) tras el ciclo cardíaco previo. El vórtice es inestable debido a su interacción con la pared del ventrículo y se destruye. Alrededor de los 0,6 segundos aparece un segundo vórtice anular, más pequeño, generado por el reflujo asociado a la onda A y que interacciona con los restos del primer vórtice. Alrededor de los 0,8 segundos, en la mitad de la sístole, gran parte de las estructuras producidas por los vórtices han desaparecido. Para E/A=0,5 el vórtice asociado a la onda E es mucho más débil, pero el asociado a la onda A es más fuerte, por lo que el flujo es más irregular alrededor de los 0,8 segundos. Para E/A=2, el vórtice E más fuerte, pero la evolución general es parecida al caso normal E/A=1,2.

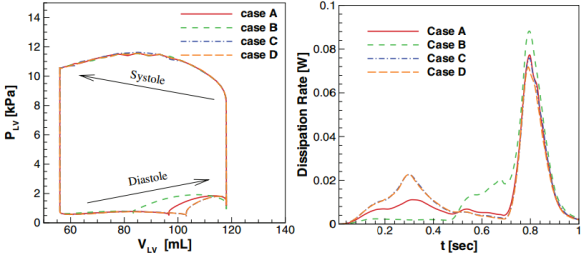

El ciclo presión-volumen permite evaluar el trabajo mecánico del ventrículo durante el ciclo cardíaco. La presión varía entre 0,6 kPa en la diástole hasta unos 11,8 kPa en la sístole. Las mayores diferencias en función del cociente E/A se observan en la diástole, siendo la sístole muy similar. Los autores han calculado la eficiencia de bombeo en función del cociente E/A, definida como el cociente entre la energía mecánica del flujo de salida por la aorta y el trabajo total realizado por el músculo cardíaco durante la sístole; esta definición permite un cálculo puramente hidrodinámico en sus simulaciones. Las diferencias en función de E/A son muy pequeñas, variando la eficiencia de bombeo entre el 97,8% y el 98%, lo que indica que el patrón del flujo no influye en la función de bombeo del ventrículo. Los autores también han calculado la energía viscosa disipada por el fluido en el ventrículo durante el ciclo cardíaco. Hay diferencias en función del parámetro E/A, pero desde el punto de vista cuantitativo son pequeñas.

En resumen, este estudio concluye que la dinámica del flujo dentro del ventrículo izquierdo para diferentes valores de E/A influye poco en su eficiencia de bombeo y tiene un impacto fisiológico pequeño. Por supuesto, los patrones de flujo son muy sensibles a la condición cardíaca y por tanto permiten estimarla, sirviendo para pronosticar muchas patologías.

Archivado en: Ciencia, Mathematics, Medicina, Noticias, Science Tagged: cardiología, Ciencia, corazón, Experimento, Física computacional, Informática, Matemática aplicada, Noticias